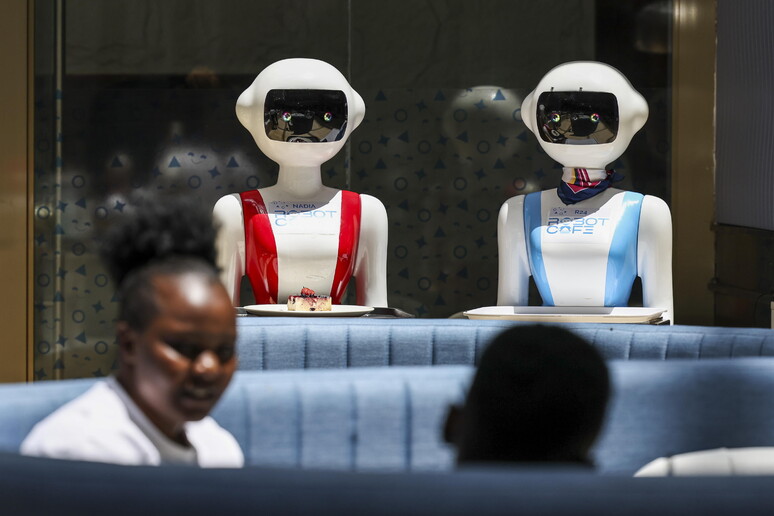

Gli strumenti di intelligenza artificiale, come assistenti e chatbot, potrebbero diventare capaci di anticipare le preferenze degli esseri umani e questa abilità potrebbe essere sfruttata a fini economici o politici. E' quanto injdica una ricerca dell'Università di Cambridge, che presenta il concetto nascente dell'economia delle intenzioni.

I ricercatori descrivono un futuro, non troppo remoto, nel quale gli assistenti IA, potendo conoscere molto degli utenti con cui comunicano, potranno spingerli a eseguire operazioni, come l'acquisto di prodotti o la scelta di un partito politico. Per i ricercatori, si passa dall'economia dell'attenzione, tipica dei social media e focalizzata sul tenere le persone incollate alle app, a una "economia delle intenzioni", in cui i software IA raccolgono informazioni che le aziende potrebbero rivendere ad altre. "Se il dato è stato la valuta dell'informatica moderna, le intenzioni umane saranno il tesoro del futuro" avvertono. "A meno che non venga regolamentata, ci sarà una corsa all'oro per coloro che prendono di mira, guidano e vendono intenzioni umane". Lo studio pone alcuni esempi che potranno verificarsi con il consolidamento dei chatbot di intelligenza artificiale. Tra questi, un assistente virtuale che, analizzando le ricerche online e gli spostamenti, suggerisce di prenotare una vacanza in una determinata località "proprio quando stavi iniziando a pensarci" dicono gli autori. Così come un sistema di raccomandazione che, basandosi sulle interazioni social, consiglia notizie e contenuti che confermano le opinioni e spingono a votare per un certo candidato politico.

"Dovremmo iniziare a considerare il probabile impatto che una simile tecnologia avrebbe sulle aspirazioni umane, tra cui elezioni eque, una stampa libera e una concorrenza di mercato leale, prima di diventare vittime delle sue conseguenze indesiderate" sono le parole di Jonnie Penn, coordinatore dello studio del Leverhulme Centre for the Future of Intelligence dell'Università di Cambridge.

Riproduzione riservata © Copyright ANSA